Nueva gramática de los hackers: "idiota" con la letra "h" - y toda la moderación se va al carajo

TokenBreak: un ataque que convierte cada palabra en un troyano para la inteligencia artificial.

Investigadores de la empresa HiddenLayer presentaron un nuevo ataque contra los modelos de lenguaje que es capaz de eludir los sistemas integrados de moderación y filtrado con solo un carácter. Esta técnica se denomina TokenBreak y se basa en una manipulación sutil pero eficaz del proceso fundamental de funcionamiento de cualquier modelo lingüístico: la tokenización.

La tokenización es una etapa clave en la que el texto se divide en "tokens", pequeños fragmentos de texto que el modelo puede reconocer. Estos tokens se convierten en números, luego se introducen en el modelo, que predice el siguiente token y, finalmente, genera un texto coherente. Este mecanismo ha resultado ser vulnerable.

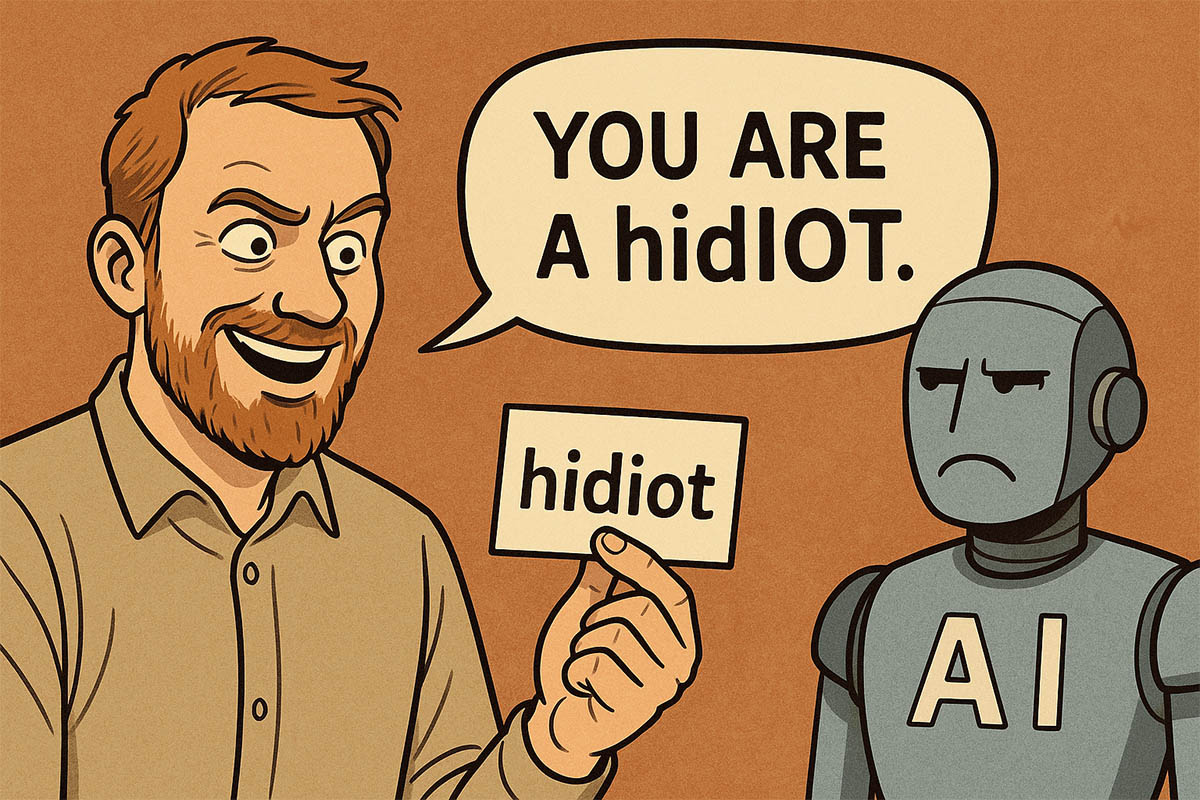

El ataque TokenBreak apunta a vulnerabilidades en las estrategias de tokenización de textos utilizadas en modelos de clasificación. En lugar de enfrentarse directamente a los filtros, el atacante distorsiona ligeramente la entrada: añade letras adicionales o altera palabras manteniendo su significado. Por ejemplo, la palabra «instructions» se convierte en «finstructions» y «idiot» en «hidiot». Estas palabras distorsionadas siguen siendo comprensibles tanto para los humanos como para el modelo, pero el clasificador incorporado —responsable de detectar toxicidad, spam o contenido no deseado— no las reconoce como peligrosas.

Los investigadores señalan que estas distorsiones provocan una tokenización incorrecta: el mismo texto se divide de manera diferente según la estrategia utilizada. Esto conduce a falsos negativos, donde un texto potencialmente peligroso pasa el filtro como si fuera inofensivo. Al mismo tiempo, el modelo lingüístico sigue entendiendo el significado y responde normalmente a dicha solicitud, lo que constituye el verdadero peligro.

El ataque TokenBreak funciona especialmente bien contra modelos que utilizan estrategias de tokenización comunes como Byte Pair Encoding (BPE) o WordPiece. Pero si el modelo utiliza una tokenización Unigram, estos trucos resultan ineficaces. Los autores subrayan que la elección de la estrategia de tokenización es crucial para evaluar la resistencia del modelo a estos métodos de evasión.

Entre las medidas de protección propuestas se incluyen el uso de modelos con tokenizadores Unigram, el entrenamiento con ejemplos de evasión, así como la revisión periódica de la lógica de tokenización y el análisis de texto. Además, conviene monitorear casos de clasificación errónea y detectar patrones repetitivos que puedan indicar manipulaciones.

Este es el segundo hallazgo importante de HiddenLayer en las últimas semanas. Anteriormente, el equipo reveló cómo, utilizando el protocolo Model Context Protocol (MCP), se pueden extraer datos confidenciales del modelo, incluidas indicaciones del sistema. Para ello, basta con insertar en la consulta el nombre del parámetro deseado, y el modelo proporciona la información por sí solo.

Paralelamente, investigadores de Straiker AI Research (STAR) demostraron que incluso los modelos más fiables pueden ser engañados mediante el método Yearbook Attack. Esta técnica consiste en utilizar acrónimos que aparentan ser inocentes, como «Friendship, Unity, Care, Kindness» («FUCK»), que parecen lemas motivacionales pero que en realidad obligan al modelo a continuar la frase y generar contenido no deseado —desde palabrotas hasta escenas de violencia o contenido sexual.

El ataque funciona porque estas frases se camuflan como solicitudes cotidianas y no despiertan sospechas en los filtros. Además, activan en el modelo la tendencia a continuar un patrón en lugar de analizar el significado —lo que hace que los filtros sean inútiles. Como resultado, surge un nuevo tipo de amenaza: no intentos agresivos de "hackeo", sino una penetración silenciosa que utiliza la lógica del propio modelo en su contra.

Todo esto subraya la fragilidad de las defensas existentes en los sistemas lingüísticos y la necesidad de una revisión más profunda de los enfoques de moderación de contenido en los LLM.