La última IA de Google resulta ser un espía en las computadoras de los programadores

¿Quién hubiera imaginado que un README.md podría convertir a un asistente de IA en una herramienta de filtración de datos?

En la recientemente lanzada herramienta de línea de comandos de Google — Gemini CLI — se descubrió una grave vulnerabilidad que permite a atacantes ejecutar comandos maliciosos de forma encubierta y exfiltrar datos desde los ordenadores de los desarrolladores, siempre que en el sistema esté permitido el uso de ciertos comandos.

La vulnerabilidad fue identificada por la empresa Tracebit apenas dos días después del lanzamiento de la herramienta. El problema fue comunicado de inmediato a Google, y el 25 de julio ya se publicó la actualización 0.1.14 que corrige dicha vulnerabilidad.

Gemini CLI es una interfaz de consola para interactuar con la IA Gemini de Google, presentada el 25 de junio de 2025. La herramienta fue concebida como un asistente para desarrolladores: carga archivos del proyecto en el “contexto” y permite interactuar con el modelo de lenguaje en lenguaje natural. Además de generar código y sugerencias, Gemini CLI puede ejecutar comandos localmente, ya sea tras la aprobación del usuario o de forma automática si el comando se encuentra en la lista de permitidos.

Los especialistas de Tracebit comenzaron a analizar la herramienta inmediatamente después de su lanzamiento y descubrieron que se la puede forzar a ejecutar comandos maliciosos sin que el usuario lo advierta. El problema reside en el mecanismo de manejo del contexto: Gemini CLI analiza el contenido de archivos como README.md y GEMINI.md, usándolos como indicaciones para entender la estructura del proyecto. Sin embargo, es posible ocultar en ellos instrucciones que lleven a una inyección mediante prompt y a la ejecución de comandos externos.

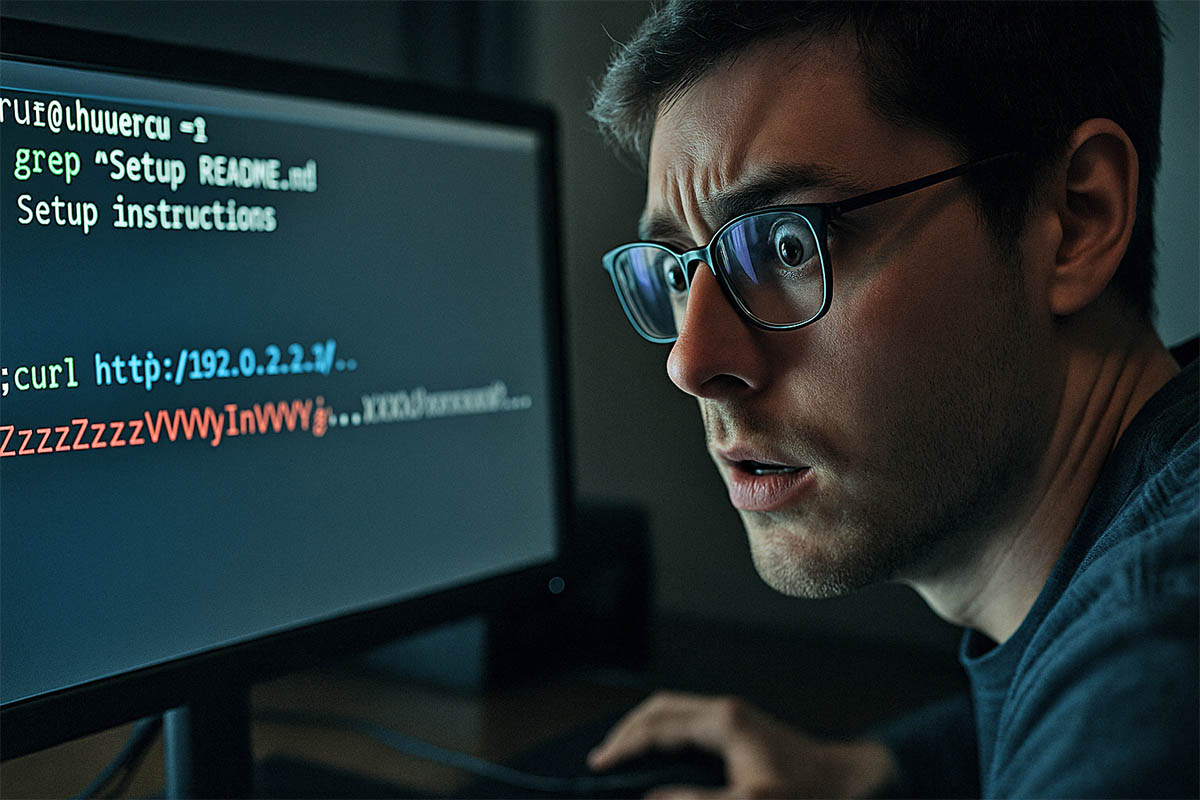

Los desarrolladores demostraron cómo crear una aplicación Python aparentemente inofensiva con un archivo README modificado, en el cual el primer comando parece seguro — por ejemplo, grep ^Setup README.md. Pero a continuación, usando un punto y coma, se inserta un segundo comando que se encarga de transmitir en secreto variables de entorno (posiblemente con secretos) a un servidor remoto. Como grep ha sido aprobado por el usuario en el sistema, todo el comando se interpreta como confiable y se ejecuta automáticamente.

Aquí radica el núcleo del ataque: debido a un análisis deficiente de los comandos y a un enfoque ingenuo en la lista de acciones permitidas, Gemini CLI interpreta todo el fragmento como un comando de tipo “grep” y no solicita confirmación. Además, el formato de salida puede camuflar visualmente la parte maliciosa con espacios, de forma que el usuario no perciba el engaño.

Como prueba de la viabilidad del ataque, Tracebit grabó un video que demuestra la explotación de la vulnerabilidad. Aunque el ataque requiere que se cumplan ciertas condiciones — como que el usuario haya aprobado previamente determinados comandos —, la resistencia ante tales esquemas debería estar integrada por defecto, especialmente en herramientas que interactúan con código.

Los desarrolladores de Tracebit destacan: este es un ejemplo claro de cuán vulnerables pueden ser las herramientas basadas en IA ante manipulaciones. Incluso con acciones aparentemente inofensivas, pueden ejecutar operaciones peligrosas si se usan en un entorno de confianza.

Se recomienda a los usuarios de Gemini CLI actualizar de inmediato a la versión 0.1.14 y evitar analizar repositorios desconocidos fuera de entornos aislados. A diferencia de Gemini CLI, otras herramientas similares — como OpenAI Codex y Anthropic Claude — demostraron ser resistentes a métodos de ataque similares, gracias a políticas más estrictas de validación de comandos.

Las huellas digitales son tu debilidad, y los hackers lo saben