«Una cascada en las montañas»: la IA aprendió a describir lo que una persona ve, directamente a partir de su actividad cerebral

Una IA puede describir escenas completas que una persona ve o imagina

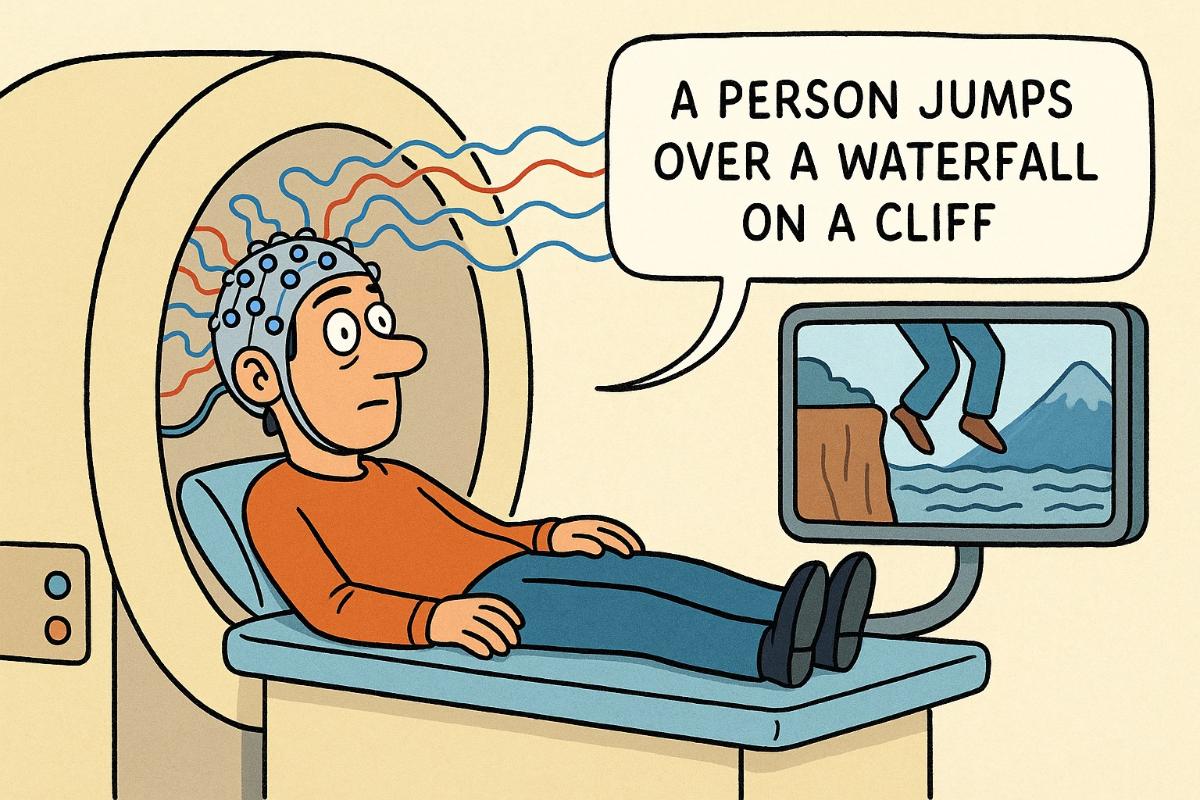

Los científicos se acercaron a la posibilidad de «leer la mente» —no metafóricamente, sino literalmente. En la revista Science Advances se publicó un trabajo de investigadores japoneses y estadounidenses que presenta una nueva tecnología denominada descripción mental. Esta es capaz, a partir de la actividad cerebral, de formar oraciones con sentido que describen lo que una persona ve o se imagina.

El método combina la resonancia magnética funcional con modelos lingüísticos y aprendizaje automático. El algoritmo analiza patrones de actividad cerebral y los asocia con «etiquetas semánticas» únicas: representaciones digitales del significado de las frases. De ese modo, el sistema puede «traducir» señales cerebrales a texto que describe la percepción o el recuerdo de la persona.

Anteriormente los investigadores solo podían identificar palabras sueltas o imágenes simples. Pero ahora los modelos han aprendido a reconstruir el contexto completo —incluyendo objetos, acciones y sus relaciones. Por ejemplo, al ver un vídeo en el que una persona salta desde una cascada, la red neuronal a partir de las señales cerebrales primero generó frases como «flujo de agua» y «sobre el agua que cae», y en la centésima aproximación produjo: «una persona salta desde una alta cascada en las montañas».

El método fue desarrollado por el neurobiólogo Tomoyasu Horikawa en los laboratorios NTT Communication Science en Kanagawa (Japón). Entrenó la red neuronal con más de 2000 videoclips y con seis participantes, cuyos datos cerebrales permitieron identificar patrones entre la percepción visual y la estructura semántica del texto. Tras ello, el sistema logró reproducir descripciones incluso de los clips que los participantes solo recordaban.

Los científicos señalan que el cerebro parece codificar las escenas vistas y las imaginadas de forma similar —esto abre nuevas vías para comprender cómo se forman los pensamientos antes de su verbalización.

Los investigadores subrayan que la tecnología es completamente no invasiva: se utiliza únicamente la resonancia magnética funcional, sin implantes. En el futuro, sistemas similares podrían ayudar a personas con trastornos del habla, por ejemplo tras un ictus, al traducir sus imágenes mentales mudas en texto.

«Si pudiéramos emplear sistemas de IA de este tipo para traducir representaciones mentales, sería un apoyo real para las personas con dificultades de comunicación», explicó Alex Huth de la Universidad de California en Berkeley, quien previamente creó un modelo similar de descifrado del lenguaje.

Sin embargo, junto con las posibilidades aumentan los riesgos. Los científicos reconocen que la aparición de estas tecnologías plantea preguntas sobre la «privacidad mental» —pues con el tiempo tales algoritmos podrían revelar emociones, intenciones y el estado de salud. Por ahora, subrayan los investigadores, sin el consentimiento del participante y sin datos de entrenamiento específicos el modelo no puede leer pensamientos arbitrarios.