Mientras ChatGPT lanza clichés, los estudiantes ganan con argumentos

La máquina escribe perfecto, pero aburre al lector — y ahí está su fracaso.

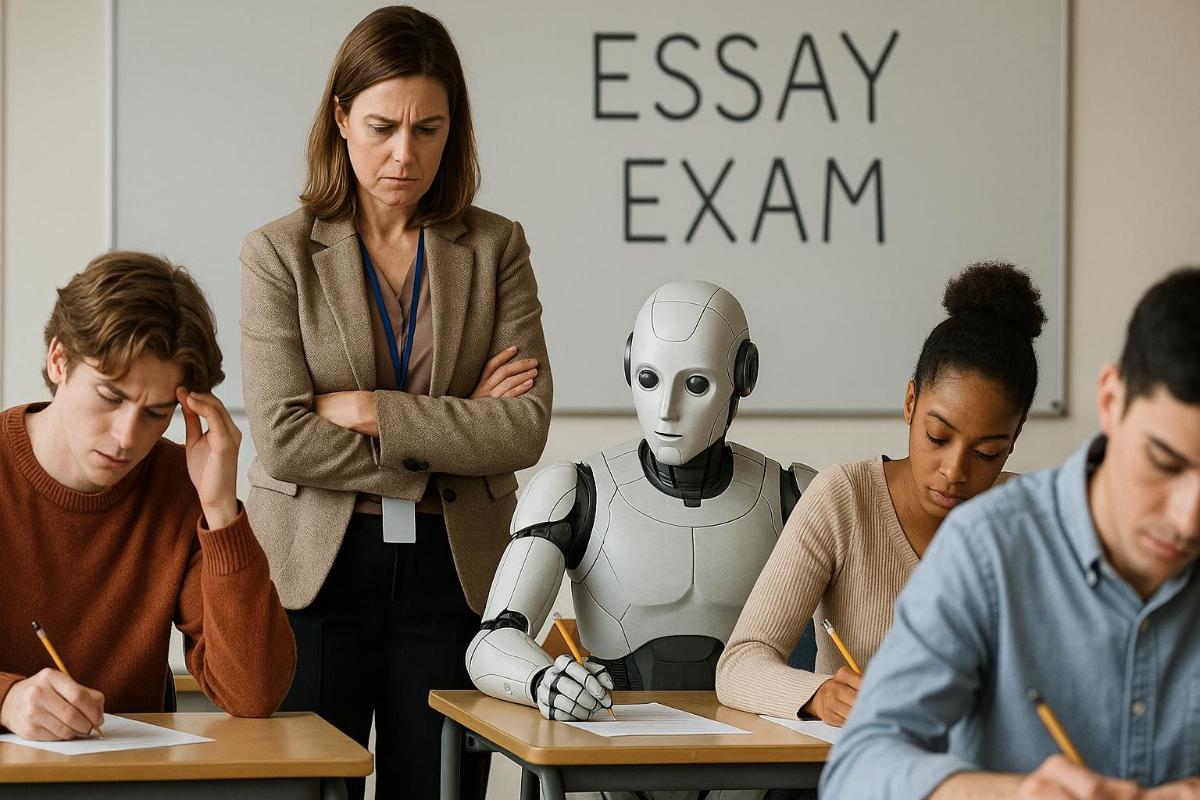

La temporada de exámenes de primavera en los centros educativos estadounidenses transcurre bajo una vigilancia intensificada: los profesores observan con atención que los estudiantes no recurran a redes neuronales para redactar sus trabajos. Sin embargo, una investigación reciente ha demostrado que la inteligencia artificial aún está muy por detrás de los humanos en el arte de la escritura. Quizás las cosas no estén tan mal como se temía.

La ola de alarma que se extendió por la comunidad educativa tras la llegada de ChatGPT es comprensible. Los modelos lingüísticos actuales logran resultados impresionantes en la creación de textos gramaticalmente correctos y lógicamente estructurados. Los profesores temen que el uso masivo de estas herramientas no solo abra nuevas puertas al engaño en los exámenes, sino también mine el desarrollo del pensamiento crítico entre los alumnos. Casos registrados a finales de 2023, en los que incluso renombrados investigadores utilizaron IA para redactar publicaciones científicas, se convirtieron en una señal de alerta para el mundo académico.

Expertos de la Universidad de East Anglia, en el Reino Unido, se propusieron estudiar a fondo el problema. Su enfoque se centró en los ensayos argumentativos, un género de escritura académica que exige construir un sistema de pruebas convincente. Compararon trabajos de 145 estudiantes con textos generados por inteligencia artificial.

Y, afortunadamente, los resultados no dejaron dudas sobre la superioridad de la inteligencia humana. Los estudiantes mostraron un nivel significativamente más alto tanto en la cantidad como en la variedad de recursos para captar la atención del lector.

El profesor Ken Hyland, uno de los líderes del estudio, describió con detalle las características distintivas del estilo humano. En sus ensayos, los estudiantes manejan hábilmente todo un arsenal de recursos retóricos: plantean preguntas directas, se apartan de la temática principal para ilustrar ideas con experiencias personales y se dirigen explícitamente al lector. Este enfoque no solo mejora la claridad de la exposición y la fuerza de los argumentos, sino que también genera un efecto de diálogo vivo.

En contraste, los textos generados por IA, a pesar de su impecabilidad lingüística y fluidez narrativa, adolecen de impersonalidad. El análisis reveló una cantidad notablemente menor de elementos destinados a interactuar con el lector. Esto se evidenció especialmente en la escasa presencia de estructuras interrogativas y la casi total ausencia de digresiones personales.

La falta de una firma autoral reconocible se convirtió en el rasgo clave que distingue a los textos generados por máquinas. Los investigadores esperan que estas diferencias ayuden a los educadores de todo el mundo —desde escuelas hasta universidades— a identificar con mayor eficacia los casos de fraude en tareas escritas, especialmente durante evaluaciones importantes.

Sin embargo, la situación se complica por la falta de herramientas técnicas fiables para detectar textos generados por IA. En el mercado proliferan los servicios de verificación de plagio de IA: desde el popular Grammarly hasta soluciones especializadas como GPTZero. El problema es que ninguno de ellos garantiza una precisión del cien por cien. Los detectores automáticos cometen errores con frecuencia, confundiendo textos humanos con creaciones algorítmicas o dejando pasar contenido generado por máquinas.