Querían desahogarse con un bot — ahora prepárense para visitas de hombres de negro

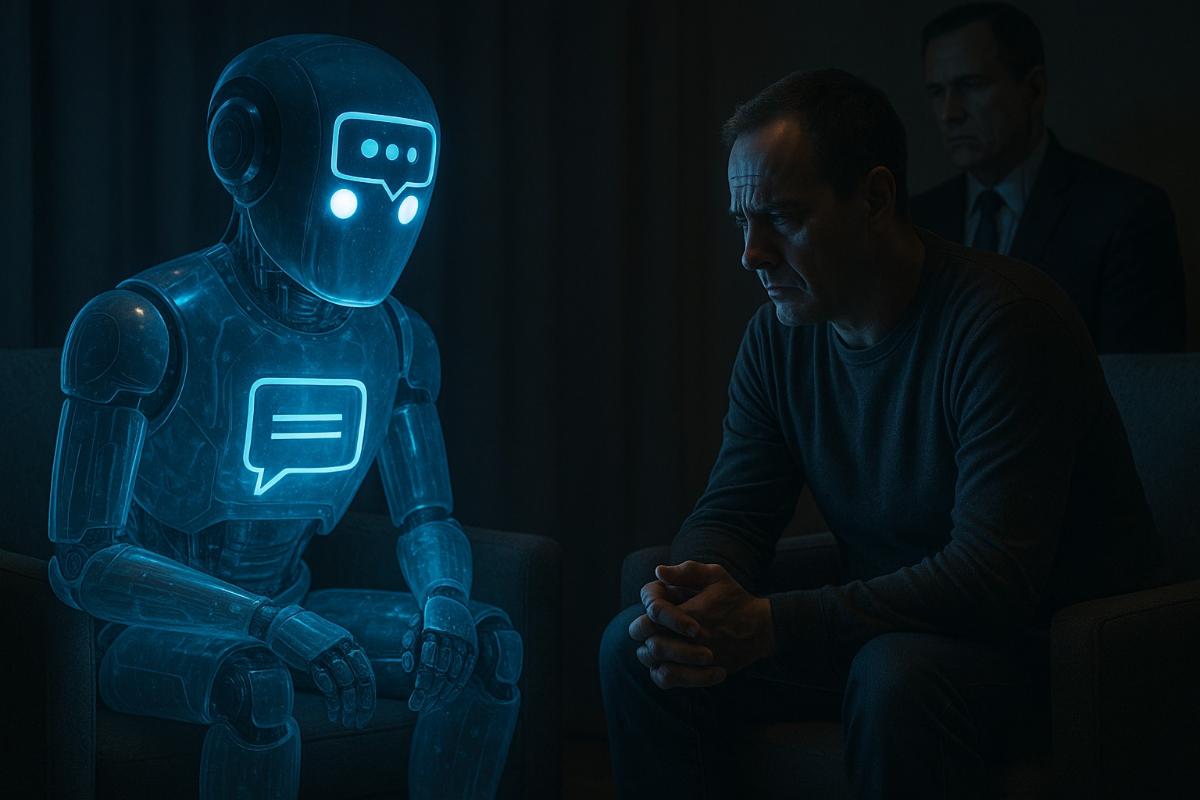

Compartieron su dolor con una IA, y ella lo compartió con el Estado — y no es una metáfora.

El director general de Meta, Mark Zuckerberg, promueve activamente una visión del futuro en la que la inteligencia artificial no sea solo una asistente, sino algo así como una consejera personal que conozca bien a la persona. En su visión, cada individuo tendrá una IA capaz de sustituir a un psicólogo —especialmente para quienes no pueden acudir a un profesional humano. Desde el punto de vista técnico, la idea ya se está materializando: millones de usuarios en todo el mundo se sinceran con chatbots. Algunos utilizan aplicaciones terapéuticas especializadas, pero muchos prefieren interactuar con plataformas universales como ChatGPT de OpenAI, Meta AI o Grok de xAI.

Sin embargo, este nuevo comportamiento se está convirtiendo en un riesgo potencial —no tanto por lo que dice el bot, sino por quién puede acceder a esas conversaciones. Bajo la apariencia de cuidado, se está desarrollando una tendencia alarmante: las corporaciones tecnológicas invitan a los usuarios a compartir sus pensamientos y emociones más íntimos, mientras que las estructuras estatales buscan recolectar la mayor cantidad posible de información personal, a menudo ignorando los límites legales y las normas éticas.

Las autoridades federales de EE. UU. ya muestran disposición a utilizar datos privados para presionar y perseguir. A inmigrantes se les niega la visa por comentarios legales, estudiantes son arrestados por artículos en periódicos, y el gobierno interviene activamente en programas académicos y medios, acusándolos de tener políticas de inclusión “inaceptables”. El ministro de Salud, Robert Kennedy Jr., propone sustituir los antidepresivos por campos de trabajo, y su departamento planea crear una base de datos federal de personas con autismo —usando historiales médicos y dispositivos portátiles.

En este contexto, un departamento llamado DOGE —dirigido por Elon Musk— intenta centralizar la recolección de datos sobre todos los estadounidenses, incluyendo información de distintas agencias gubernamentales. Sus primeras acciones incluyeron la revelación de datos de funcionarios poco conocidos, acompañada de ataques dirigidos en línea.

Mientras tanto, las grandes plataformas de IA se han convertido en los principales canales de confesión para millones de usuarios. Y estas plataformas están en manos de personas que claramente buscan acercarse a Donald Trump. Musk trabaja para el gobierno, Zuckerberg hace lobby en favor de los intereses de Meta, y Sam Altman de OpenAI respalda las prioridades de la administración Trump, como levantar restricciones al sector energético y oponerse a la regulación estatal de la IA. Incluso Google, detrás de Gemini AI, actúa con cautela en la misma dirección.

Mientras los usuarios comparten sus miedos, pensamientos suicidas, cuestiones de identidad de género o injusticias raciales, las autoridades ganan cada vez más poder de intervención. Son especialmente vulnerables aquellos que ya están en el foco: trabajadores de la salud, activistas, personal universitario y representantes de ONGs. Incluso una frase aislada en un chat podría desencadenar una visita del servicio de inmigración o una auditoría sobre “políticas DEI ilegales” en una organización.

Los chatbots, en esencia, amplifican las vulnerabilidades del internet tradicional. Las conversaciones con ellos suelen ser más íntimas y emocionales que las búsquedas en línea. Sin embargo, no están protegidas con cifrado de extremo a extremo, como los chats en aplicaciones de mensajería. Y aunque las empresas prometen proteger los datos, no hay garantía de que no los entreguen ante la primera exigencia —especialmente bajo presión o manipulación.

La experiencia de años anteriores, incluyendo los programas de vigilancia de la NSA y los sistemas de espionaje masivo revelados por Edward Snowden, demostró cuán fácil y silenciosamente puede el Estado acceder a los datos más íntimos. Ahora, en lugar de llamadas telefónicas, son conversaciones con IA, y vigilarlas resulta aún más sencillo.

En este escenario, cualquier consecuencia es posible: desde la filtración de conversaciones personales hasta la intromisión directa en la vida privada. Y todo puede presentarse bajo el pretexto de proteger a los niños, combatir el terrorismo o brindar asistencia médica.

Las empresas podrían elevar los estándares de privacidad, especialmente en aplicaciones de IA que simulan terapia. Por ejemplo, aplicando principios de HIPAA o implementando soluciones tecnológicas que impidan el acceso a registros. Pero en lugar de eso, las mismas corporaciones apoyan a políticos interesados en reprimir la libertad de expresión y controlar la vida privada de los ciudadanos.

Representantes de Meta* y OpenAI no ofrecieron detalles sobre las medidas de protección de datos personales. En cambio, enfatizaron que sus IAs no sustituyen a los médicos y, si es necesario, recomiendan acudir a profesionales. xAI y Google declinaron hacer comentarios. Aunque aún no hay pruebas de un monitoreo masivo de los registros de IA, la realidad se acerca rápidamente a una distopía. Cada vez más noticias suenan como teorías conspirativas que ayer parecerían absurdas. Y dado lo personales que se han vuelto las conversaciones con la IA, estas pueden convertirse en la nueva puerta de entrada al control total.