La IA se metió en Wikipedia… y casi expulsó a los humanos

Algo salió mal con la IA, y lo sintieron todos los que aún creen en el trabajo hecho a mano.

La Fundación Wikimedia ha suspendido temporalmente un experimento de generación automática de resúmenes breves de artículos que se mostraban a los usuarios de Wikipedia al principio de la página. El motivo fue una reacción negativa, casi unánime, de la comunidad de editores, que consideró esta iniciativa perjudicial para la reputación y los principios del proyecto.

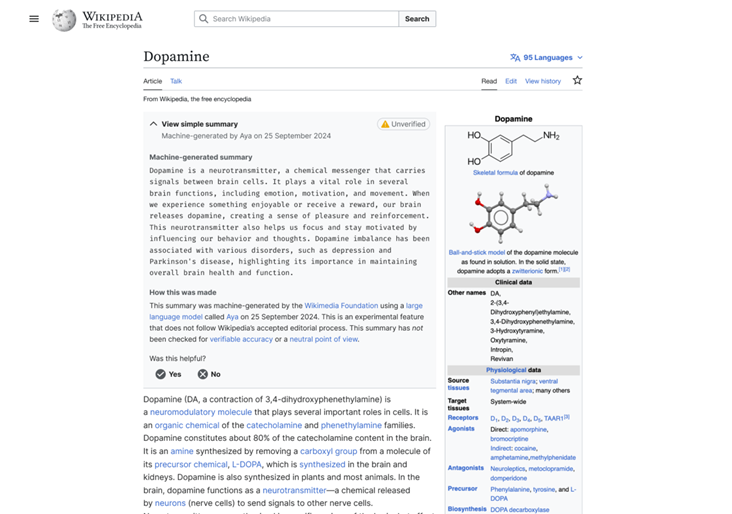

Los resúmenes eran generados mediante el modelo Aya de la empresa Cohere y aparecían en una extensión del navegador de Wikipedia. Se mostraban en la parte superior del artículo con una marca amarilla que decía «Unverified» y se desplegaban al hacer clic. Oficialmente, el experimento comenzó el 2 de junio y debía durar dos semanas, siendo voluntario y limitado a la versión móvil del sitio. Sin embargo, tras una avalancha de críticas negativas, fue cancelado rápidamente.

Resumen breve generado por IA (404 Media)

Muchos miembros de la comunidad reaccionaron con dureza ante la introducción de IA generativa. Uno de los editores calificó el experimento como un insulto directo a la inteligencia de los lectores, subrayando que Wikipedia se ha convertido en un símbolo de fiabilidad y sobriedad precisamente gracias al enfoque manual y a la exclusión de la «estridencia» y el contenido algorítmico. Señaló que el proyecto corre el riesgo de perder la confianza y «profanar décadas de trabajo sobre políticas de veracidad».

Los editores dejaron en masa comentarios lacónicos y duros — desde «absolutamente no» hasta «la peor idea». La principal crítica fue que un único texto generado automáticamente y colocado en la parte superior de la página destruye el modelo colaborativo de edición y no deja espacio para opiniones alternativas, violando así el principio de punto de vista neutral. Según los participantes del debate, esto contradice la idea de la wiki como enciclopedia viva y colectiva.

El experimento, llamado «Simple Article Summaries», fue propuesto tras debates durante la conferencia Wikimania en 2024, donde surgieron ideas sobre el uso del reformulado automático para simplificar textos complejos. Sin embargo, incluso los partidarios de la idea señalaron la necesidad de marcar claramente el contenido generado por IA y de contar con un sistema de moderación que permitiera señalar errores o inexactitudes fácilmente.

Un representante de la Fundación declaró que el objetivo era hacer más accesibles los artículos complejos para lectores con distintos niveles de formación. También subrayó que la incorporación de IA al trabajo en Wikipedia solo será posible con la participación activa de los editores y con herramientas de control adecuadas.

Más tarde, un portavoz del proyecto reconoció que el diálogo con la comunidad no fue suficientemente claro ni transparente. Según sus palabras, el debate debía haberse iniciado antes, en marzo, en la plataforma técnica VPT, para preparar a los editores y abrir una discusión completa.

Aunque el experimento ha sido suspendido, la Fundación destaca que el interés por las capacidades de la IA generativa sigue vigente. No obstante, cualquier proyecto futuro se llevará a cabo solo con la participación de la comunidad y tomando en cuenta la experiencia de esta situación. La decisión final sobre el desarrollo de tales funciones se tomará conjuntamente con los editores, no de forma unilateral.

El valor semántico de Wikipedia ha cobrado una importancia especial en tiempos de saturación masiva de internet con contenido generado por IA. Mientras que grandes plataformas como Google buscan implementar resúmenes automáticos, Wikipedia sigue siendo un bastión del trabajo manual y de la información verificada. Y, a juzgar por la reacción de la comunidad, sus miembros están dispuestos a luchar por mantener estos principios.

En octubre de 2024, un grupo de editores entusiastas de Wikipedia lanzó un nuevo proyecto llamado WikiProject AI Cleanup. Su objetivo es hacer frente a la avalancha de contenido de baja calidad creado por inteligencia artificial. La iniciativa busca identificar y eliminar textos mal escritos o inexactos que puedan deteriorar la calidad general de la información en la plataforma.

No esperes a que los hackers te ataquen: ¡suscríbete a nuestro canal y conviértete en una fortaleza impenetrable!