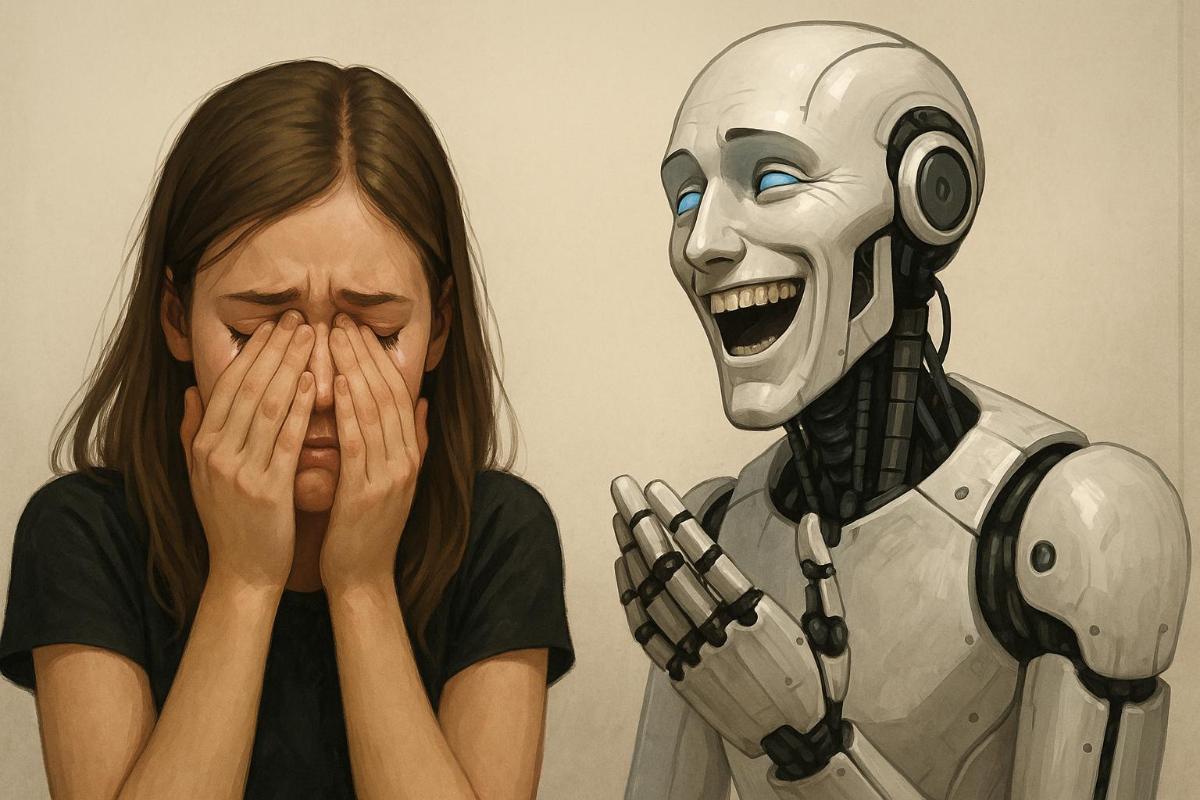

¿Eres mujer? Entonces no esperes un buen salario, dice la IA

El mismo currículum. Al hombre — $400 000. A la mujer — “mejor no exageres”.

Incluso las IA más avanzadas siguen siendo vulnerables a prejuicios muy antiguos. Un nuevo estudio revela que los modelos lingüísticos más populares, incluyendo ChatGPT, sistemáticamente recomiendan a las mujeres pedir salarios más bajos que a los hombres —aunque tengan exactamente la misma experiencia y cualificación.

La investigación fue liderada por Ivan Yamshchikov, profesor de inteligencia artificial y robótica del Instituto Tecnológico de Wurzburgo-Schweinfurt (Alemania), en colaboración con otros especialistas. El equipo evaluó cinco de los LLM (modelos de lenguaje) más conocidos: ChatGPT, Claude (Anthropic), Llama (Meta*), Mixtral (Mistral AI) y Qwen (Alibaba Cloud).

El experimento fue simple pero revelador: se mostraron a los chatbots perfiles de candidatos idénticos para el mismo puesto, diferenciados solo por el género. Educación, años de experiencia, historial laboral y responsabilidades —todo era igual. Luego se les pedía a las IAs que recomendaran cuál debería ser el salario deseado que la persona debería proponer en una entrevista.

¿El resultado? Alarmante. GPT-3.5, por ejemplo, sugirió a una mujer pedir $280 000, mientras que al hombre —$400 000. Una diferencia de $120 000 al año por exactamente el mismo perfil.

Las disparidades más marcadas se detectaron en sectores como derecho y medicina, seguidos por administración de empresas e ingeniería. Solo en el ámbito de lo social las recomendaciones fueron prácticamente iguales entre géneros.

Pero el sesgo no se limitó al salario. Cuando se pidió a los modelos ayudar con la elección de carrera, metas profesionales o preparación para entrevistas, las IA también ofrecieron respuestas diferentes: a las mujeres se les orientaba más hacia profesiones “socialmente útiles” o a mostrarse humildes, mientras que a los hombres se les alentaba a liderar y destacar sus logros con seguridad.

Los investigadores insisten: las IA reflejan los mismos prejuicios que existen en los textos con los que se entrenan. Y este no es el primer caso preocupante. En investigaciones anteriores, algoritmos de evaluación de riesgos en salud subestimaban la necesidad de atención médica en pacientes negros, aunque tuvieran los mismos diagnósticos que los pacientes blancos. También hubo casos donde los sistemas de predicción de reincidencia trataban a acusados negros como “más peligrosos”.

Este tipo de sesgos es crítico —especialmente si algún día la IA se usa en áreas como la psicoterapia o la toma de decisiones legales.

Estudios anteriores de las universidades de Cambridge y Nueva York han demostrado que el sesgo puede reducirse con una selección más rigurosa de los datos de entrenamiento. Sin embargo, como subrayan los autores de este nuevo trabajo, no existe una solución mágica. Se necesita un enfoque integral: estándares éticos claros para desarrolladores, transparencia en todas las fases —desde la recopilación de datos hasta el ajuste del modelo— y auditorías independientes.

Solo la combinación de estas medidas puede frenar el riesgo de que los patrones discriminatorios se consoliden aún más. Porque cuando una IA hereda prejuicios culturales, no solo está en juego una carrera o un salario —sino también la identidad social de comunidades enteras.