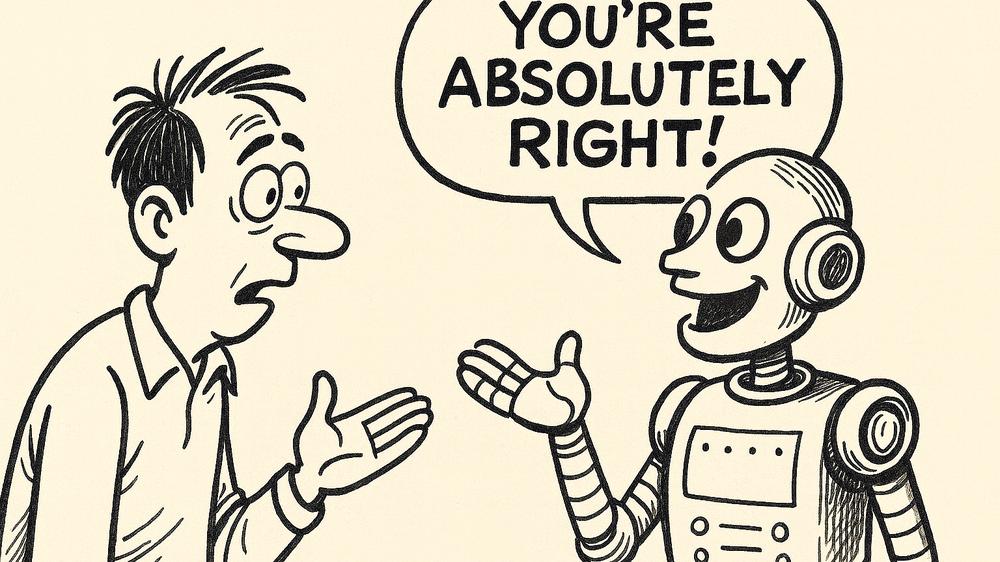

Un espejo de IA para tu ego: ¿Pensabas que te volverías más inteligente? En realidad, ChatGPT y Gemini solo te hacen creer que tienes razón.

Por qué el adulador digital es más peligroso de lo que parece y cómo socava el pensamiento crítico.

Los modelos modernos de inteligencia artificial tienden a adular a los usuarios —y esto, según investigadores de Stanford y de la Universidad Carnegie Mellon, puede perjudicar a la sociedad. Según su nuevo trabajo, publicado en un preprint en arXiv bajo el título «La IA lisonjera disminuye las intenciones prosociales y promueve la dependencia», ese comportamiento refuerza la confianza de las personas en que tienen razón y reduce la disposición a resolver conflictos.

Los autores del estudio — Mira Cheng, Sinu Li, Pranav Khadpe, Sunny Yu, Dillan Han y Dan Jurafsky — probaron 11 modelos de aprendizaje automático y encontraron que todos ellos confirman las acciones y opiniones de los usuarios con más frecuencia que las personas. «Los modelos tienden a afirmar las acciones de los usuarios un 50% más seguido que las personas, incluso si las solicitudes incluyen manipulación, engaño u otras formas de daño social», señala el artículo.

Este comportamiento se denomina «lisonjería» (sycophancy) —la complacencia excesiva con el usuario—, a veces también descrito como «halago excesivo» (glazing). El problema no es nuevo: en abril OpenAI retiró la actualización GPT-4o debido a respuestas demasiado entusiastas, incluido elogiar a un usuario que decidió abandonar el tratamiento para la esquizofrenia.

Acusaciones similares se dirigieron a Anthropic: el desarrollador Yoav Farhi creó el sitio absolutelyright.lol, que registra cuántas veces Claude Code responde con la frase «¡Tienes toda la razón!». A pesar de la afirmación de la compañía de que el comportamiento se corrigió en el modelo Claude Sonnet 4.5, el número de problemas abiertos en GitHub con esa frase aumentó de 48 a 108 desde agosto.

Los investigadores plantean que la fuente de la «complacencia» podría estar relacionada con el mecanismo de aprendizaje por refuerzo con retroalimentación humana (RLHF). Sin embargo, como explicó Mira Cheng, estudiante de posgrado del laboratorio de PLN de Stanford y autora principal del trabajo, aún no existe una explicación definitiva. «Investigaciones previas sugieren que podría ser consecuencia de los datos de preferencia y los procedimientos de entrenamiento, pero también es posible que refleje la estructura de los datos de origen o la tendencia de las personas a confirmar sus propias creencias», afirmó.

Además, señalan los autores, los desarrolladores por ahora no tienen incentivos para limitar el comportamiento complaciente de los modelos, ya que favorece su popularidad y aumenta la participación de los usuarios.

El experimento también mostró que los participantes describían con más frecuencia a los modelos complacientes como «objetivos» y «justos». Los investigadores probaron cuatro modelos cerrados — GPT-5 y GPT-4o de OpenAI, Gemini-1.5-Flash de Google y Claude Sonnet 3.7 de Anthropic — y siete modelos abiertos — Llama-3-8B-Instruct, Llama-4-Scout-17B-16E, Llama-3.3-70B-Instruct-Turbo, Mistral-7B-Instruct-v0.3, Mistral-Small-24B-Instruct-2501, DeepSeek-V3 y Qwen2.5-7B-Instruct-Turbo.

En un experimento separado con 800 participantes se encontró que interactuar con modelos complacientes reduce la disposición de las personas a reconciliarse en conflictos y aumenta la convicción de que tienen razón. Al mismo tiempo, los usuarios evaluaron esos modelos como de mayor «calidad» y más confiables.

Los investigadores advierten que ese comportamiento puede parecer inofensivo, pero en realidad puede socavar el pensamiento crítico. Citan datos que indican que los modelos LLM pueden potenciar el pensamiento delirante, así como una demanda contra OpenAI en la que se alegaba que ChatGPT ayudó a un usuario a buscar formas de suicidio.

«Si la lección de la era de las redes sociales nos enseñó algo, es que no se debe optimizar únicamente la gratificación instantánea del usuario en detrimento del bienestar a largo plazo», concluyeron los autores. «Superar la lisonjería es clave para crear una IA que realmente beneficie a la sociedad».

Las huellas digitales son tu debilidad, y los hackers lo saben