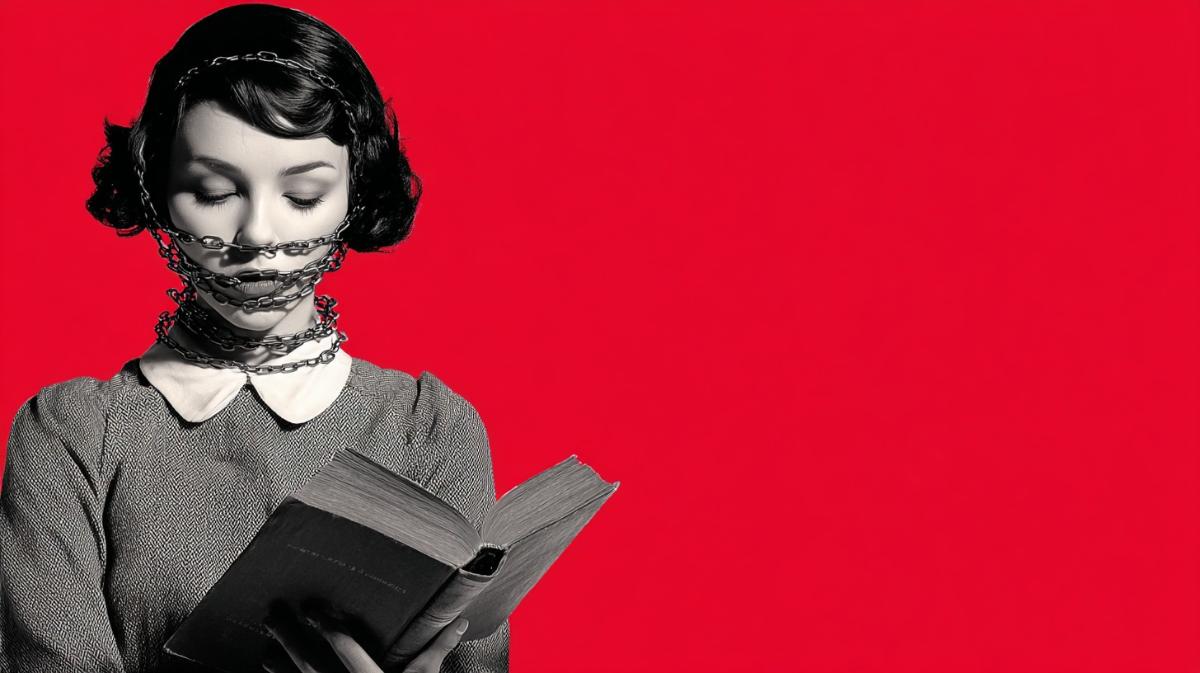

Semáforo literario: la luz roja ordena sustituir — ahora las máquinas deciden qué leen los lectores

La IA amenaza con borrar el pensamiento crítico

En los últimos años, las bibliotecas y escuelas estadounidenses se han visto afectadas por un doble golpe: campañas de censura de libros y la implantación masiva de inteligencia artificial, que cada vez se utiliza más para la «automatización» del control del contenido de las colecciones bibliográficas.

Uno de los ejemplos recientes es el sistema actualizado Class-Shelf Plus, desarrollado por la organización Children's Literature Comprehensive Database (CLCD). Su objetivo es ayudar a las bibliotecas a rastrear libros y a cumplir con nuevas leyes que restringen el acceso a materiales «sensibles». La tercera versión del programa incluye funciones de «análisis automatizado de riesgos» y «evaluación de la sensibilidad del contenido» basadas en inteligencia artificial. El sistema usa un modelo de clasificación que asigna a cada publicación un nivel de riesgo en formato semáforo y sugiere «alternativas seguras» en lugar de obras que encajan en categorías controvertidas.

Los desarrolladores afirman que su herramienta permite a los distritos escolares acelerar el proceso de verificación del cumplimiento de los requisitos estatales y reducir el trabajo manual en un 80%. Sin embargo, para muchos bibliotecarios y docentes este enfoque ha sido una señal de alarma: un algoritmo sin comprensión contextual se convierte en una herramienta de censura. Un documento interno de CLCD, que describe el funcionamiento de Class-Shelf Plus, pone como ejemplo «eludir la prohibición de un libro», pero en la práctica muestra lo contrario: la inteligencia artificial propone sustituir la obra por otra en la que falta el «contenido disputado».

La dirección de CLCD califica esto como un paso hacia la transparencia y una protección para los docentes frente a acusaciones de parcialidad. El sistema debería ayudar a los distritos escolares a mostrar al público qué libros están disponibles y cuáles requieren una revisión adicional. Pero en la práctica eso significa que la decisión sobre qué considerar «material de riesgo» se delega al algoritmo, que evalúa las obras por rasgos formales, excluyendo la interpretación humana y el contexto pedagógico.

Según los bibliotecarios, cada día reciben decenas de propuestas de empresas que ofrecen implementar herramientas similares. En los catálogos se infiltran masivamente libros generados automáticamente —cientos de «pseudoediciones» creadas por redes neuronales que no pasan por revisión editorial. Hay que filtrarlos manualmente para proteger a los lectores de la desinformación y las falsificaciones. Al mismo tiempo, la dirección de las instituciones exige cada vez más la adopción de inteligencia artificial, supuestamente para optimizar procesos laborales, mientras que los recursos para el trabajo directo con los lectores disminuyen.

Paralelamente, aumenta la presión política. En los últimos años en EE. UU. ha crecido de forma notable el número de iniciativas legislativas dirigidas contra docentes, bibliotecarios e investigadores acusados de «sesgo ideológico». Bajo lemas como la lucha contra la «teoría crítica de la raza» y el «contenido perverso» se desarrollan campañas que cuestionan la propia existencia de bibliotecas públicas y de programas educativos dedicados a la historia del racismo, la igualdad y los derechos de las minorías. En este contexto, las ideas de «selección automática de contenido» y de «evaluación objetiva de riesgos» encuentran apoyo entre quienes buscan establecer un control centralizado sobre la información.

La inteligencia artificial en estos procesos actúa como acelerador. La promueven grandes corporaciones, organismos gubernamentales y grupos de presión política que la ven como una herramienta de «eficiencia». Según esa lógica, el trabajo humano, la experiencia profesional y la creatividad pasan a ser innecesarios: la máquina puede en segundos ofrecer una evaluación lista, sustituyendo al analista, al docente o al bibliotecario. Pero como resultado se borra la posibilidad de un pensamiento matizado. Cuando un modelo decide qué es «inaceptable», desaparece el espacio para el debate y el análisis crítico.

Los bibliotecarios advierten que la implantación masiva de esos sistemas de hecho legaliza la filtración de conocimientos. Un algoritmo entrenado con conjuntos de datos limitados excluirá sistemáticamente temas relacionados con la raza, el género, la sexualidad y los conflictos históricos. En un contexto en el que las instituciones educativas están obligadas a cumplir las normativas de los estados, la «verificación automática de contenido» se convierte en una herramienta de control político y no en una tecnología neutral.

Al mismo tiempo, las bibliotecas se enfrentan a otras consecuencias de la «IAización»: un flujo de textos de baja calidad y publicaciones falsas creadas por modelos generativos. Plataformas como Hoopla ya se vieron obligadas a eliminar de sus catálogos cientos de libros falsos. Pero el volumen de spam crece más rápido de lo que los moderadores pueden reaccionar.

A nivel institucional, las tendencias tecnológicas y políticas se entrelazan. En documentos programáticos de movimientos conservadores como la Heritage Foundation y del proyecto Project 2025 se describen planes para reducir el número de funcionarios públicos y docentes, sustituyéndolos por algoritmos y sistemas de «análisis automático de rendimiento». Objetivos similares persiguen funcionarios que ven en la IA un medio para «combatir la ineficiencia» y «detectar abusos». El resultado es un círculo cerrado: se acusa a las personas responsables del desarrollo del conocimiento público de parcialidad y se las desplaza, mientras la inteligencia artificial sustituye el juicio humano por un automatismo irresponsable.

Los trabajadores de bibliotecas y del sector educativo reconocen que los últimos años han sido una prueba difícil. Están sometidos continuamente a presión —desde amenazas e insultos hasta recortes y revisión de programas. A esto se suma ahora la carga de adaptarse a sistemas que prometen «ayudar», pero que en realidad limitan la libertad de actuación. Todo ello va acompañado de agotamiento emocional y sensación de futilidad cuando el trabajo reflexivo es reemplazado por la «automatización» impuesta.

Esta transformación conduce a que el acceso libre al conocimiento se convierta en un privilegio y no en un derecho. Las niñas y los niños crecen en contextos donde los libros pasan por filtros digitales, se excluyen temas «indeseados» y los docentes temen abordar cuestiones complejas. Las investigaciones cada vez más las realizan no personas, sino sistemas cerrados de inteligencia artificial desarrollados por empresas afiliadas a estructuras políticas. Las instituciones educativas, al querer mostrar «innovación», participan en programas de subvenciones para la implementación de IA y con ello aumentan la dependencia de tecnologías que controlan el acceso a la información.

Los especialistas advierten que esa fusión de censura y análisis automatizado convierte a las bibliotecas y las escuelas en elementos de un ecosistema informativo gestionado. En ese contexto, el conocimiento queda subordinado a filtros ideológicos y la confianza pública en expertos y científicos se va erosionando. En un mundo donde un algoritmo sustituye el juicio profesional, desaparece la cultura de verificación de hechos y el pensamiento crítico. Y eso es, según investigadores, lo que convierte a la inteligencia artificial y a las tendencias autoritarias en aliados naturales: no porque persigan los mismos fines, sino porque ambos aceleran el proceso de degradación del conocimiento humano.