Google hace todo lo posible para que creas en su IA 'privada': la compañía lanzó Private AI Compute

Empresa garantiza tráfico de usuarios con anonimato máximo e imposible de rastrear.

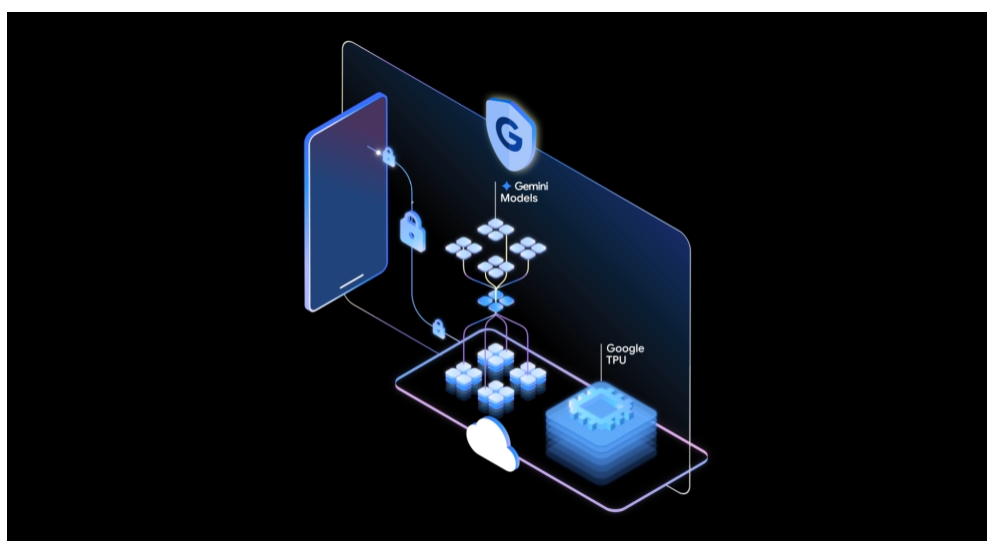

Google presentó el nuevo sistema de protección de datos Private AI Compute, destinado a procesar solicitudes de inteligencia artificial en la nube sin riesgo de divulgación de información personal. Según la compañía, la tecnología crea un entorno protegido en el que se pueden aprovechar las capacidades de los modelos en la nube Gemini, manteniendo la confidencialidad de todos los datos de los usuarios.

Private AI Compute se describe como una plataforma de cómputo aislada, reforzada, que combina las ventajas del rendimiento en la nube con un nivel de protección que normalmente se logra con el procesamiento local en el dispositivo. La arquitectura se basa en los procesadores Trillium TPU y en los entornos Titanium Intelligence Enclaves, que combinan alta potencia de cálculo con garantías criptográficas de seguridad.

Para implementar este concepto, Google se apoya en una infraestructura de hardware de nodos de confianza construidos sobre procesadores AMD y que emplean un Entorno de Ejecución Confiable (TEE). Este mecanismo garantiza el cifrado de la memoria RAM y su aislamiento del sistema host, impidiendo el acceso a las tareas en ejecución incluso por parte de los administradores. Solo las cargas de trabajo verificadas y atestadas se permiten ejecutar en el entorno de confianza, y los intentos de extracción física de datos del equipo se bloquean a nivel de arquitectura.

Una característica importante de Private AI Compute es el soporte para la atestación mutua y el cifrado de extremo a extremo entre nodos de confianza. Esto garantiza que la información del usuario se descifre y procese únicamente dentro del perímetro de confianza, completamente aislado de la infraestructura general de Google. Cada componente verifica la autenticidad del otro mediante validación criptográfica, y el acceso a las claves se concede solo después de que el nodo supere las comprobaciones internas de referencia. En caso de discrepancia en los parámetros, la conexión no se establece, lo que impide la transferencia de datos a segmentos no confiables.

El proceso de interacción se organiza en un esquema multinivel. El cliente inicia una conexión protegida con el servidor frontend mediante el protocolo Noise y realiza la atestación mutua. A continuación se verifica la autenticidad del servidor dentro de la sesión cifrada Oak, lo que permite asegurarse de que el canal de comunicación no haya sido suplantado.

Después de esto, el servidor crea un canal cifrado ALTS para intercambiar datos con otros servicios dentro de la canalización escalable de inferencia, y las solicitudes a los modelos se procesan en plataformas TPU protegidas. Todo el sistema está diseñado desde el inicio como efímero: los datos, las solicitudes y los cálculos se destruyen inmediatamente después de finalizar la sesión. Incluso si un atacante obtuviera privilegios elevados, no podría recuperar la información de sesiones pasadas.

Esquema de Private AI Compute (Google)

Para prevenir cualquier intento de intervención no autorizada, Google incorporó en la infraestructura una serie de mecanismos de protección. Entre ellos: la reducción del número de componentes de confianza para garantizar la confidencialidad; el uso del sistema Confidential Federated Compute para recopilar estadísticas anonimizadas; el cifrado total de las comunicaciones cliente-servidor; la autorización binaria, que garantiza la ejecución solo de configuraciones firmadas y verificadas; el aislamiento de los datos de los usuarios en máquinas virtuales; la protección de la memoria y de los canales de E/S mediante IOMMU para impedir la extracción física de datos; la prohibición total de acceso al intérprete de comandos en el entorno TPU; el tunelizado de todo el tráfico entrante a través de retransmisores IP de operadores terceros para ocultar la fuente real de la solicitud; y un sistema separado de autenticación y autorización que utiliza tokens anónimos y no está vinculado al procesamiento de solicitudes de IA.

La seguridad de la plataforma fue verificada de forma independiente por NCC Group, que auditó Private AI Compute entre abril y septiembre de 2025. Los especialistas identificaron varias vulnerabilidades potenciales, incluido un canal de temporización en el módulo de retransmisión IP que, en ciertas condiciones, podía utilizarse para desanonimizar a los usuarios. Sin embargo, Google evaluó este riesgo como bajo, señalando que la arquitectura multiusuario genera un alto nivel de ruido que dificulta la correlación de las solicitudes con usuarios concretos.

Además, los auditores detectaron tres problemas en el mecanismo de atestación que podrían derivar en denegaciones de servicio y errores de protocolo. La compañía informó que trabaja en medidas para corregir todas las deficiencias identificadas. A pesar del uso de componentes de hardware propietarios y de la centralización del sistema en Borg Prime, los investigadores destacaron el alto nivel de protección de los datos de los usuarios frente a un procesamiento no autorizado y la limitación de las capacidades incluso para posibles atacantes internos.

En esencia, Private AI Compute sigue la misma lógica que iniciativas similares de otros grandes actores. Apple implementó anteriormente Private Cloud Compute, y Meta implementó el mecanismo Private Processing, que también permiten enviar solicitudes de inteligencia artificial a la nube sin comprometer la privacidad. Google subraya que su solución combina las capacidades de cálculo del entorno en la nube con garantías de cifrado por hardware y atestación transparente. Los dispositivos de los usuarios se conectan al entorno protegido mediante verificación criptográfica remota y canales cifrados, y los modelos Gemini procesan los datos dentro de un segmento aislado al que no tiene acceso ni la propia compañía ni terceros participantes.

Así, la nueva arquitectura crea la base tecnológica para unas computaciones en la nube seguras de próxima generación, donde la potencia de los centros de datos se combina con los principios de privacidad local, y el control sobre los datos permanece exclusivamente en manos del propietario.