Un portátil común frente al universo: nuevo emulador afronta el mayor reto de la cosmología

Cómo una red neuronal superó a las supercomputadoras.

Científicos de un equipo internacional, que incluye especialistas del Instituto Nacional de Astrofísica de Italia (INAF), de la Universidad de Parma y de la Universidad de Waterloo (Canadá), desarrollaron el emulador Effort.jl para modelar la estructura a gran escala del Universo.

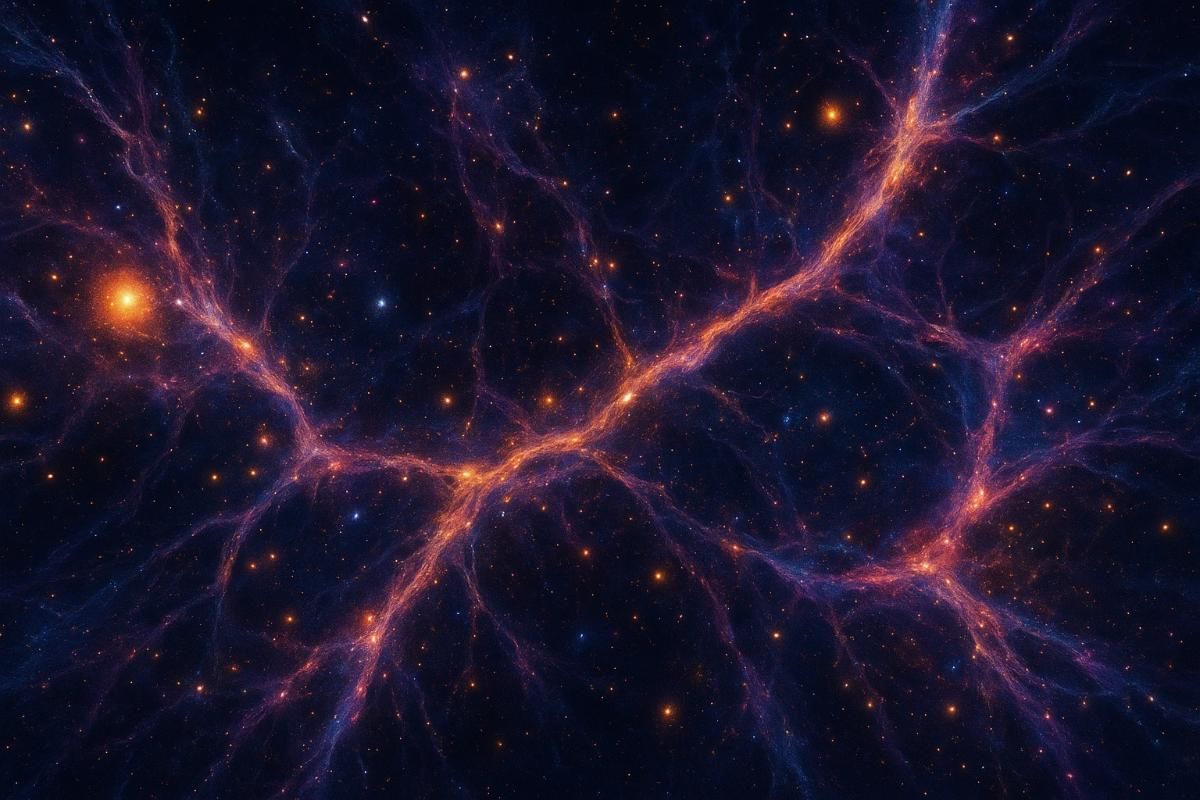

Se trata de una de las tareas más complejas de la cosmología: describir la «red cósmica» —una gigantesca red tridimensional donde las galaxias forman cúmulos y supercúmulos, conectados por filamentos y separados por vacíos. Para su análisis se emplea el modelo EFTofLSS (la teoría efectiva de campo de la estructura a gran escala), que describe estadísticamente la distribución de la materia en el Universo y permite calcular sus parámetros clave. Pero este modelo exige enormes recursos computacionales, y el volumen de datos astronómicos no deja de crecer —prueba de ello son los conjuntos recientes del proyecto DESI o la misión Euclid.

Para reducir el tiempo de procesamiento, se usan emuladores. No resuelven las ecuaciones de nuevo, sino que «imitan» cómo se comporta el modelo, produciendo resultados similares decenas o cientos de veces más rápido. Effort.jl, creado por el equipo, supuso un avance significativo: funciona en minutos en un portátil común en lugar de semanas en un superordenador y al mismo tiempo mantiene la precisión.

Como explica el primer autor del estudio, Marco Bonici de la Universidad de Waterloo, la teoría efectiva de campo es similar a la descripción del agua en un vaso. En principio se podría considerar el movimiento de cada molécula o átomo, pero eso es poco práctico: el número de cálculos crece de forma desmesurada. En lugar de ello se pueden fijar las propiedades microscópicas clave y seguir su influencia a escala macroscópica —en este caso, el movimiento del fluido en su conjunto. De la misma manera, la EFTofLSS describe el Universo: los procesos físicos a pequeña escala están codificados en parámetros, y la teoría trabaja con la estructura en su conjunto.

Effort.jl se basa en una red neuronal que se entrena con los resultados del modelo real y luego predice sus respuestas para nuevas combinaciones de parámetros. A diferencia de otros emuladores, el nuevo emulador utiliza información ya conocida sobre cómo cambian las predicciones cuando varían los parámetros —esto está integrado en el algoritmo desde el inicio. Además, tiene en cuenta los gradientes, es decir, la dirección y la magnitud de los cambios ante pequeños desplazamientos de un parámetro. Todo ello reduce el tamaño de la muestra de entrenamiento y acelera el proceso.

La cuestión principal al usar atajos de este tipo es si se puede confiar en el resultado. Los autores muestran que la precisión de Effort.jl en datos sintéticos y reales coincide con la del modelo original. Además, a veces el emulador permite incluir aquellas partes del análisis que en los cálculos habituales se descartaban para acelerar el proceso.